O norte-americano John Hopfield e o inglês Geoffrey Hinton foram os laureados com o Nobel de Física de 2024. A Academia Real das Ciências da Suécia, órgão responsável pela premiação, fez o anúncio na manhã desta terça-feira (8), reconhecendo a contribuição dos pesquisadores em “descobertas e invenções fundamentais que permitiram o aprendizado de máquina (machine learning, em inglês) com redes neurais artificiais”. A dupla irá dividir o prêmio de 11 milhões de coroas suecas, o equivalente a mais de R$ 5 milhões.

“Os laureados deste ano usaram conceitos fundamentais da física estatística para desenvolver redes neurais artificiais, capazes de encontrar padrões em grandes bancos de dados”, afirmou Ellen Moons, Presidente do Comitê do Nobel de Física, durante o anúncio nesta manhã. Segundo a pesquisadora, as descobertas da dupla compõem as bases fundamentais do aprendizado de máquina e geraram impactos em áreas que vão desde a física de partículas ao reconhecimento facial e ao diagnóstico de doenças. “Hoje temos uma grande quantidade de dados gerados de diversas maneiras. Buscamos obter informações a partir desses dados, encontrar padrões ou fazer previsões. E as ferramentas de aprendizado de máquina auxiliam justamente nessas tarefas”, explica Alexandre Reily Rocha, pesquisador do Instituto de Física Teórica da Unesp, campus de São Paulo.

Seja de maneira perceptível, como o uso de ferramentas de tradução ou do chat GPT, ou em circunstâncias menos evidentes, como na seleção automática de fotos pelo Google, o uso de Inteligência Artificial é parte importante do nosso dia a dia. Mesmo assim, Rocha destaca que a premiação surpreendeu vários pesquisadores. “Já existia o consenso de que os métodos de aprendizado de máquina ganhariam o Nobel em algum momento. Mas não se imaginava que aconteceria este ano”, conta o físico, que associa o surgimento e a popularização do Chat GPT à maior atenção recebida pela área.

No período entre a década de 1980, quando Hopfield e Hinton iniciaram suas primeiras pesquisas, e os dias de hoje, o aprendizado de máquina utilizando redes neurais artificiais avançou a passos acelerados. É graças ao desenvolvimento destas técnicas que os computadores de hoje, embora ainda não serem capazes de pensar, conseguem executar diversas tarefas complexas que requerem a imitação de funções mentais humanas, como a memória e a capacidade de aprendizado.

A capacidade de adaptação é o que torna o aprendizado de máquina diferente de outros tipos de softwares e sistemas de inteligência artificial. Enquanto um software tradicional segue uma série de regras e instruções pré-definidas, o aprendizado de máquina aproveita as informações a que o software tem acesso para melhorar seu funcionamento e aumentar sua eficiência e sua acurácia. Já as redes neurais artificiais representam o método por meio do qual o aprendizado de máquina efetivamente ocorre.

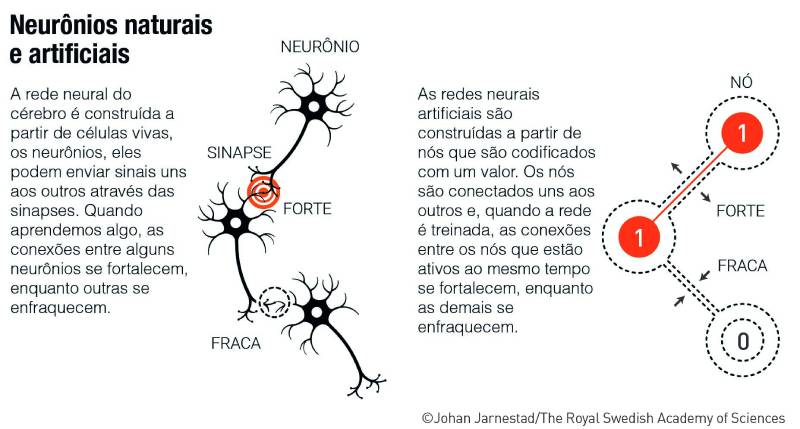

A busca pelo desenvolvimento de máquinas capazes de emular o cérebro humano vem desde os anos 1940, e demandou contribuições de pesquisadores de áreas como matemática, psicologia e neurociência. As primeiras redes neurais artificiais surgiram da tentativa de recriar o funcionamento do cérebro humano em simulações computacionais. Nelas, os neurônios são representados por nós, e as sinapses por conexões entre esses nós, que podem ser fortalecidas ou enfraquecidas. A partir desse princípio as redes artificiais passam por treinamentos para desempenharem tarefas específicas — por exemplo, para reconhecer imagens. Quando a tarefa de reconhecimento é executada com sucesso, as conexões entre os nós são fortalecidas. Em contrapartida, quando a rede falha no processo, as conexões se enfraquecem. Assim, por meio deste sinal, a máquina consegue aprender quais conexões são melhores, ou mais corretas.

A memória associativa em computadores

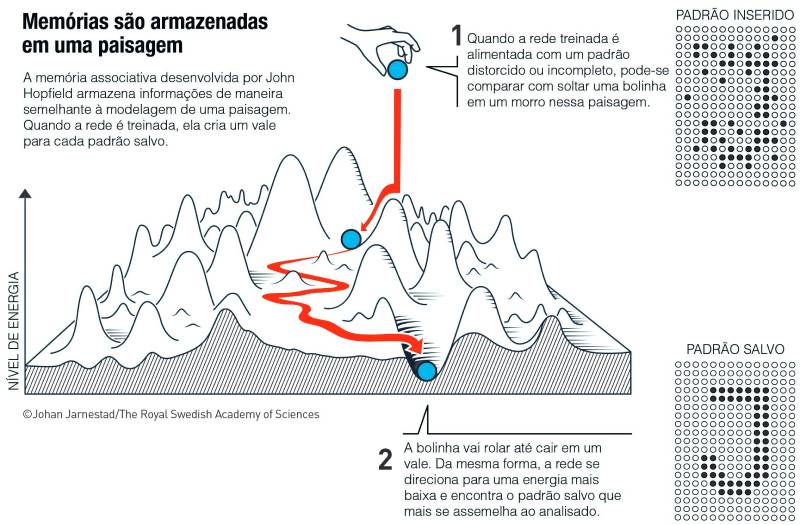

Embora essas ideias tenham surgido ainda no começo dos anos 1940, o campo ganhou fôlego apenas em 1982, quando Hopfield desenvolveu uma rede capaz de armazenar e recriar padrões, em um processo semelhante à memória associativa. Essa é a capacidade humana de conseguir lembrar de determinadas informações a partir de outros conceitos e ideias relacionados. Por exemplo, ao ouvir a palavra “fogo”, é possível que algumas pessoas associem às queimadas no pantanal, ou ao incêndio do Museu Nacional, ou mesmo a experiências individuais. Com a Hopfield Network, o laureado conseguiu que a máquina seguisse um caminho de associação semelhante: quando a rede recebia algum padrão incompleto, ou mesmo distorcido, ela se mostrava capaz de encontrar em sua memória o padrão similar mais correto.

De maneira simplificada, a rede de Hopfield funciona como se dispusesse de um certo tipo de memória visual. Ela é alimentada com uma imagem, onde cada ponto é representado por um número 0 ou 1. Com essa informação, ela ajusta suas conexões, ou sinapses para que a imagem tenha uma “energia baixa”, considerado o perfil mais desejável. Assim, quando uma nova imagem é inserida, a rede analisa a nova informação ponto a ponto, tendo na memória os padrões de menor energia da imagem anterior. Se ela encontrar um ponto onde é melhor trocar a cor (do preto para o branco, ou do 0 para o 1, por exemplo), ela fará este procedimento com o objetivo de reduzir a energia. Desta forma, a rede analisa toda a imagem até que não sejam necessários mais ajustes, recriando, assim, com a menor energia possível, uma imagem semelhante à original.

Segundo o Comitê do Nobel, Hopfield compara esse processo com uma bola rolando em uma paisagem de picos e vales. Se a bola for solta em um determinado local, ela vai rolar até o vale mais próximo e parar naquele local. De maneira semelhante, se a rede receber um padrão que esteja próximo a algum dos padrões que ela tem salvos na memória, ela continuará ajustando a imagem até chegar no “fundo do vale”, encontrando o padrão que mais se aproxima daquilo que ela possui armazenado em seus arquivos.

Máquinas que interpretam informações

Com sua rede, Hopfield desvendou a chave para que computadores fossem capazes de identificar imagens a partir da sua memória. Porém, será que as máquinas seriam capazes de interpretar essas informações com o objetivo de, por exemplo, criar categorias de imagens representando um mesmo objeto? Essa era a motivação por trás dos estudos de Hinton, acompanhado de seu colega Terrence Sejnowsk, na Universidade de Carnegie Mellon, Estados Unidos.

Os pesquisadores aproveitaram a Rede de Hopfield para expandir sua aplicação, utilizando conceitos vindos da física estatística. A principal ideia aplicada foi a de observar o comportamento dos sistemas como um todo, em vez de olhar para a ação de cada nó individualmente. Muitos dos sistemas que existem no mundo são compostos por uma infinidade de elementos. Um gás, por exemplo, é composto por milhares de moléculas, e a humanidade abrange bilhões de pessoas. A identificação de padrões no comportamento de tais sistemas é uma tarefa extremamente complicada, se nos debruçarmos individualmente sobre cada molécula, ou cada pessoa. Entretanto, ferramentas de física estatística permitem analisar esses comportamentos de maneira coletiva e, desta forma, compreender diferentes propriedades de cada sistema estudado.

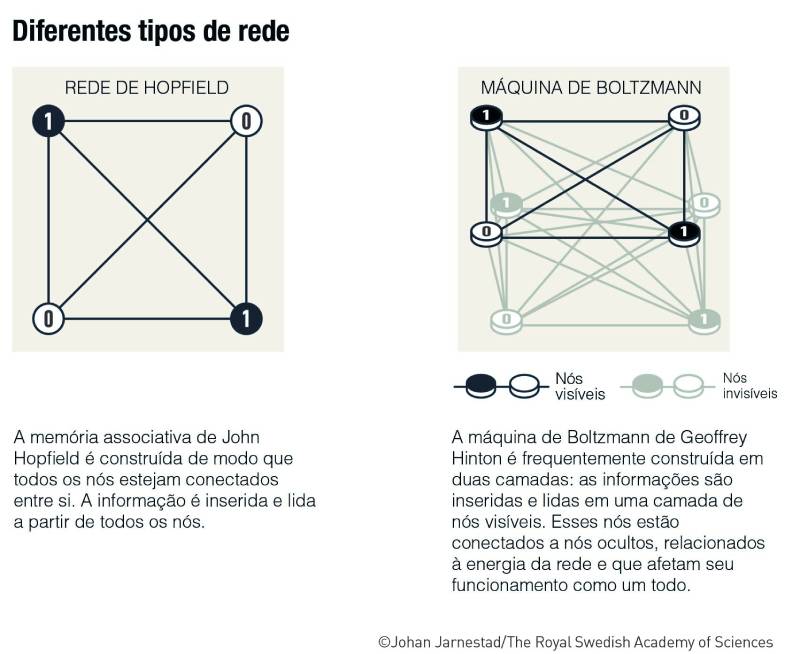

Hinton partiu desse princípio para criar a máquina de Boltzmann, apresentada em um trabalho em 1985, e nomeada em homenagem ao físico Ludwig Boltzmann, que desenvolveu uma equação utilizada para mostrar quais estados são mais prováveis em um sistema, a depender da energia disponível. A partir da combinação das redes neurais, desenvolvidas por Hopfield, com os princípios da física estatística, Hinton criou uma máquina que era capaz de utilizar sua memória para interpretar e criar novos dados a partir das informações inseridas em seu sistema. Essas características fazem dessa invenção um dos primeiros modelos de Inteligência Artificial Generativa, hoje popularizados pelo Chat GPT.

A máquina de Boltzmann utiliza dois tipos de nós, ou neurônios, diferentes: um grupo, chamado nós visíveis, recebe a informação; um segundo grupo compõe a camada invisível, cuja função é contribuir para a energia e funcionamento da rede. Cada nó conta com um valor que é alterado, um por um, pela máquina, com a intenção de criar diferentes combinações que, por sua vez, darão origem a novos padrões. A equação de Boltzmann entra nesta etapa: cada combinação possível apresenta uma chance determinada de se materializar. Esta chance seria o estado do sistema, que é calculado a partir da energia da rede.

Esse funcionamento permite que a máquina aprenda, a partir de exemplos que são inseridos em seu sistema. Seu processo de treinamento envolve a apresentação de alguns padrões, como imagens ou dados, que levam a máquina a ajustar suas conexões de forma a entender quais determinados padrões apresentam chances maiores ou menores de aparecer.

Se um padrão específico for mostrado várias vezes durante o treinamento, as chances de que a máquina consiga reconhecer e reproduzir esse padrão aumentam. Ela também se torna capaz de criar novos padrões, que se assemelham aos exemplos a que teve acesso, mesmo que tais padrões não sejam exatamente iguais aos originais. Isso permite à máquina reconhecer características familiares no interior de imagens as quais não teve acesso anteriormente, tornando-a capaz de estabelecer um conhecimento sobre as categorias de objetos.

Desde seu desenvolvimento inicial até hoje, a máquina de Boltzmann passou por muitas atualizações e melhorias. Hoje ela é usada como um elemento de redes de inteligência artificial muito maiores, e empregada, por exemplo, na recomendação de filmes e músicas com base no histórico do usuário.

Impactos da Inteligência Artificial

“O trabalho dos laureados já trouxe grandes benefícios. Na física, nós utilizamos redes neurais artificiais em uma ampla gama de áreas, como no desenvolvimento de novos materiais com propriedades específicas”, afirma Moons. A área de materiais é o campo de pesquisa de Rocha, que afirma: “as ferramentas de aprendizado de máquina transformaram completamente o campo, especialmente nos últimos cinco anos. Elas inauguraram um novo paradigma que chamamos de ‘materials discovery’”. O uso do aprendizado de máquina possibilitou acelerar a descoberta de novos materiais, otimizando processos e auxiliando na previsão de propriedades que podem ser encontradas em diversos materiais em desenvolvimento, como novos supercondutores, por exemplo.

Outros exemplos recentes de aplicação desse tipo de Inteligência Artificial incluem a análise e ca ategorização de centenas de imagens de asteroides, o que possibilitou a descoberta de novas famílias dessas rochas espaciais. Também foram essenciais na análise da enorme quantidade de dados produzidos pelo LHC e que levaram à identificação do Bóson de Higgs. O aprendizado de máquina também se faz presente no futuro da física, agora que grandes instalações como o Observatório Vera Rubin preveem a produção de bilhões de novos dados, que seriam impossíveis de serem analisados e tratados sem a utilização dessas ferramentas. “De certa forma, o Nobel está premiando essa evolução. É, provavelmente, um prêmio ‘de toda a física’, não de uma área específica”, diz Rocha.

A era do aprendizado de máquina também transformou a indústria. Rocha cita como exemplo a empresa nVIDIA, conhecida por desenvolver placas de vídeo potentes para videogames e computadores. Hoje, embora a companhia ainda mantenha tais produtos em sua linha de montagem, seu carro chefe passou a ser a produção de hardwares utilizados na exploração desse tipo de inteligência artificial.

A semana de premiações teve início ontem (7), com os norte-americanos Victor Ambros e Gary Ruvkun recebendo a láurea de Medicina pela descoberta de microRNAs, pequenos fragmentos de RNA que controlam a atividade de genes dentro das células. Os anúncios do Nobel continuam com o prêmio de Química (9), o de Literatura (10), o da Paz (11), e o de Economia na próxima segunda (14), encerrando a série. A cerimônia de entrega dos prêmios será realizada no dia 10 de dezembro.

Ilustração de John J. Hopfield (esquerda) e Geoffrey E. Hinton (direita). Crédito: Ill. Niklas Elmehed © Nobel Prize Outreach